通知设置 新通知

日内操作 8月1日 躺死

股票 • 绫波丽 发表了文章 • 0 个评论 • 2869 次浏览 • 2016-08-01 23:42

而满上的那2成仓位,又是新开的仓。 今天看盘就绿3个点,1分钟不到就冲到跌停,之后全天在水下波动。 没有任何起色。

所以今天及其被动。 如果大盘有波动,但自己却不能动弹,是一个操作失误。

无论怎样,都要保留一成仓位。

满仓ing。

日亏损: 2% 查看全部

而满上的那2成仓位,又是新开的仓。 今天看盘就绿3个点,1分钟不到就冲到跌停,之后全天在水下波动。 没有任何起色。

所以今天及其被动。 如果大盘有波动,但自己却不能动弹,是一个操作失误。

无论怎样,都要保留一成仓位。

满仓ing。

日亏损: 2%

社保停交后,医保处于被冻结状态,不能使用。

默认分类 • 李魔佛 发表了文章 • 0 个评论 • 8139 次浏览 • 2016-07-30 12:30

医疗保险指通过国家立法,按照强制性社会保险原则基本医疗保险费应由用人单位和职工个人按时足额缴纳。不按时足额缴纳的,不计个人帐户,基本医疗保险统筹基金不予支付其医疗费用。

医疗保险是为补偿疾病所带来的医疗费用的一种保险。职工因疾病、负伤、生育时,由社会或企业提供必要的医疗服务或物质帮助的社会保险。如中国的公费医疗、劳保医疗。

中国职工的医疗费用由国家、单位和个人共同负担,以减轻企业负担,避免浪费。发生保险责任事故需要进行治疗是按比例付保险金。

医疗保险在退休时必须积累一定的缴费年限(含视同缴费年限),一般规定为20年-30年,并且实际缴费年限必须达到5年(或10年),才可以在退休以后免费终身享受医疗保险保障待遇。如果在退休时的累计缴费年限不足规定要求,可以按当时的费率标准补交所差的医疗保险缴费年限。

职工医疗保险补缴:

一、医保机构征缴部门根据医疗保险欠费情况,建立欠费数据信息,填制《社会保险费补缴通知单》,通知参保单位补缴欠费。

二、对因筹资困难,无法一次足额缴清欠费的参保单位,医保机构征缴部门与其签订社会保险补缴协议。如欠费单位发生被兼并、分立、破产等情况时,按下列方法签订补缴协议。

1、欠费单位被兼并的,与兼并方签订补缴协议。

2、欠费单位分立的,与各分立方签订补缴协议。

3、欠费单位进入破产程序的,与清算组签订清偿协议。

4、单位被拍卖出售或租赁的,与主管部门签订补缴协议。

三、参保单位根据《社会保险费补缴通知单》或补缴协议办理补缴,医保机构征缴部门予以受理,并通知医保机构财务管理部门收款。

四、破产单位无法完全清偿的欠费,医保机构征缴部门受理单位破产清算组提出的申请,审核后送稽核监督部门处理。

五、医保机构征缴部门依据财务管理部门传来的职工医疗保险补缴欠费到账信息和稽核监督部门传来的核销信息,调整参保单位欠费信息。

也就是说,你工作了20年,但是突然想放松一下,间隔年一下,去个游山玩水,社保中断了交。 这个时候你的社保卡是冻结状态,这个时候你的社保卡不能到医院看病。 除非你去游山玩水期间,自己去交社保的钱,不中断。

这种政策真扯淡。 所以说,国家的这些政策,完全弊大于利。 医保上的钱,如果我自己全部自己拿着,去理财,福利收益20年怎么也可以翻一翻吧,一年年收益只需要几个点就够了。(1+1*x)**20=2, (其中x为年收益率,**20 是20次方,复利计算公司), 可以算出 x=3.5%, 指数运算差点忘记了擦。

而且我爱什么时候用就什么时候用, 不要考虑中断不中断。 反正呢,ZF想要把你的口袋的钱放到他们那里,所以这笔钱,你不能动,其实我心里已经把当做这笔钱花了出去,看病能拿回一点算一点, 心里一种强烈被剥削的感觉。

查看全部

社保停交后,医保处于被冻结状态,不能使用。

医疗保险指通过国家立法,按照强制性社会保险原则基本医疗保险费应由用人单位和职工个人按时足额缴纳。不按时足额缴纳的,不计个人帐户,基本医疗保险统筹基金不予支付其医疗费用。

医疗保险是为补偿疾病所带来的医疗费用的一种保险。职工因疾病、负伤、生育时,由社会或企业提供必要的医疗服务或物质帮助的社会保险。如中国的公费医疗、劳保医疗。

中国职工的医疗费用由国家、单位和个人共同负担,以减轻企业负担,避免浪费。发生保险责任事故需要进行治疗是按比例付保险金。

医疗保险在退休时必须积累一定的缴费年限(含视同缴费年限),一般规定为20年-30年,并且实际缴费年限必须达到5年(或10年),才可以在退休以后免费终身享受医疗保险保障待遇。如果在退休时的累计缴费年限不足规定要求,可以按当时的费率标准补交所差的医疗保险缴费年限。

职工医疗保险补缴:

一、医保机构征缴部门根据医疗保险欠费情况,建立欠费数据信息,填制《社会保险费补缴通知单》,通知参保单位补缴欠费。

二、对因筹资困难,无法一次足额缴清欠费的参保单位,医保机构征缴部门与其签订社会保险补缴协议。如欠费单位发生被兼并、分立、破产等情况时,按下列方法签订补缴协议。

1、欠费单位被兼并的,与兼并方签订补缴协议。

2、欠费单位分立的,与各分立方签订补缴协议。

3、欠费单位进入破产程序的,与清算组签订清偿协议。

4、单位被拍卖出售或租赁的,与主管部门签订补缴协议。

三、参保单位根据《社会保险费补缴通知单》或补缴协议办理补缴,医保机构征缴部门予以受理,并通知医保机构财务管理部门收款。

四、破产单位无法完全清偿的欠费,医保机构征缴部门受理单位破产清算组提出的申请,审核后送稽核监督部门处理。

五、医保机构征缴部门依据财务管理部门传来的职工医疗保险补缴欠费到账信息和稽核监督部门传来的核销信息,调整参保单位欠费信息。

也就是说,你工作了20年,但是突然想放松一下,间隔年一下,去个游山玩水,社保中断了交。 这个时候你的社保卡是冻结状态,这个时候你的社保卡不能到医院看病。 除非你去游山玩水期间,自己去交社保的钱,不中断。

这种政策真扯淡。 所以说,国家的这些政策,完全弊大于利。 医保上的钱,如果我自己全部自己拿着,去理财,福利收益20年怎么也可以翻一翻吧,一年年收益只需要几个点就够了。(1+1*x)**20=2, (其中x为年收益率,**20 是20次方,复利计算公司), 可以算出 x=3.5%, 指数运算差点忘记了擦。

而且我爱什么时候用就什么时候用, 不要考虑中断不中断。 反正呢,ZF想要把你的口袋的钱放到他们那里,所以这笔钱,你不能动,其实我心里已经把当做这笔钱花了出去,看病能拿回一点算一点, 心里一种强烈被剥削的感觉。

日内操作 7月29日 特停政策下游资休养生息

股票 • 绫波丽 发表了文章 • 0 个评论 • 2702 次浏览 • 2016-07-30 11:06

何况其他?

为何自己目前还满仓运行?

错误

何况其他?

为何自己目前还满仓运行?

错误

日内操作 7月28日 价投的天下 中小创的地狱

股票 • 绫波丽 发表了文章 • 0 个评论 • 2562 次浏览 • 2016-07-29 11:23

板块相应出来了,可惜自己一直持有的中小创。

板块相应出来了,可惜自己一直持有的中小创。

git 比较两个分支的不同

Linux • 李魔佛 发表了文章 • 0 个评论 • 5587 次浏览 • 2016-07-28 22:31

===================================

补充:找到答案:// >> 后加输出文件的路径、文件名和后缀名 git diff [branchA] [branchB] >>d:/diff/exportname.diff

查看全部

git diff [branchA] [branchB]用以上这个命令可输出两个分支的区别,但是不同的文件太多,在命令行查看不是很方便,想输出到文件中查看,不知道如何加参数?

===================================

补充:找到答案:// >> 后加输出文件的路径、文件名和后缀名 git diff [branchA] [branchB] >>d:/diff/exportname.diff

git冲突 解决

Linux • 李魔佛 发表了文章 • 0 个评论 • 4519 次浏览 • 2016-07-28 22:06

在提交单个文件的时候出现这个错误.

意思是不能部分提交代码.

原因是git认为你有部分代码没有做好提交的准备,比如没有添加

解决方法是

1. 提交全部

git commit -a

2. 如果不想提交全部,那么可以通过添加 -i 选项

git commit file/to/path -i -m "merge"

上述情况一般出现在解决本地working copy冲突时出现, 本地文件修改(手工merge)完成后,要添加并提交,使得本地版本处于clean的状态.

这样以后git pull就不再会报错.

冲突处理

当两条分支对同一个文件的同一个文本块进行了不同的修改,并试图合并时,Git不能自动合并的,称之为冲突(conflict)。解决冲突需要人工处理。

比如当前在master分支,想把dev分支merge过来,结果产生了一个冲突,打开文件内容可以看到这么一个冲突:[复制代码]

<<<<<<< HEAD test in master ======= test in dev >>>>>>> dev

[复制代码]

<<<<<<<标记冲突开始,后面跟的是当前分支中的内容。

HEAD指向当前分支末梢的提交。

=======之后,>>>>>>>之前是要merge过来的另一条分支上的代码。

>>>>>>>之后的dev是该分支的名字。

对于简单的合并,手工编辑,然后去掉这些标记,最后像往常的提交一样先add再commit即可。 查看全部

在提交单个文件的时候出现这个错误.

意思是不能部分提交代码.

原因是git认为你有部分代码没有做好提交的准备,比如没有添加

解决方法是

1. 提交全部

git commit -a

2. 如果不想提交全部,那么可以通过添加 -i 选项

git commit file/to/path -i -m "merge"

上述情况一般出现在解决本地working copy冲突时出现, 本地文件修改(手工merge)完成后,要添加并提交,使得本地版本处于clean的状态.

这样以后git pull就不再会报错.

冲突处理

当两条分支对同一个文件的同一个文本块进行了不同的修改,并试图合并时,Git不能自动合并的,称之为冲突(conflict)。解决冲突需要人工处理。

比如当前在master分支,想把dev分支merge过来,结果产生了一个冲突,打开文件内容可以看到这么一个冲突:[复制代码]

<<<<<<< HEAD test in master ======= test in dev >>>>>>> dev

[复制代码]

<<<<<<<标记冲突开始,后面跟的是当前分支中的内容。

HEAD指向当前分支末梢的提交。

=======之后,>>>>>>>之前是要merge过来的另一条分支上的代码。

>>>>>>>之后的dev是该分支的名字。

对于简单的合并,手工编辑,然后去掉这些标记,最后像往常的提交一样先add再commit即可。

怎么segmentfault上的问题都这么入门级别的?

python • 李魔佛 发表了文章 • 0 个评论 • 2309 次浏览 • 2016-07-28 16:37

基本都是一些菜鸟的问题。

搜索关键字: python

出来的是

结果都是怎么安装python,选择python2还是python3 这一类的问题。 着实无语。

看来在中国肯义务分享技术的人并不像国外那么多,那么慷慨。

(也有可能大神们都在忙于做项目,没空帮助小白们吧) 查看全部

如何使用pandas把某些行的数据进行算术处理?

回复量化交易-Ptrade-QMT • 李魔佛 发起了问题 • 1 人关注 • 0 个回复 • 5889 次浏览 • 2016-07-28 15:35

每天输出一篇高质量文章 ---始于2016年7月28日

30天新尝试 • 李魔佛 发表了文章 • 0 个评论 • 2807 次浏览 • 2016-07-28 12:36

平时太多的输入,但是输出很少。 这好比学校里学了很多东西,但是不做作业,不考试,这样永远无法知道学生的水平。

即使质量不高,我也要坚持。 百篇里能出一篇也不错。

平时太多的输入,但是输出很少。 这好比学校里学了很多东西,但是不做作业,不考试,这样永远无法知道学生的水平。

即使质量不高,我也要坚持。 百篇里能出一篇也不错。

日内操作 7月27日 大盘暴跌

股票 • 绫波丽 发表了文章 • 0 个评论 • 2544 次浏览 • 2016-07-27 16:28

几周的努力都付诸东流。 股市注定是一个1盈2平7亏得地方。

而我,大概率的落到了7亏得那大部分人里。

不想说太多技术的东西。

午盘开盘前,11点多的时候可以跑掉,但是心里总是心存侥幸。 希望下午尾盘能有机会V上去。 股市里最怕的就是这种希望,没有凭借概率说话。

没有概率上的胜率,只能期盼奇迹。 但是,奇迹是小概率事件,期待奇迹的发生,不是一个胜者该做的。

多回顾,多反省,多空仓。 纪律和模式的重要性,会让你能够避免失血过多而在股市存活下来。 查看全部

几周的努力都付诸东流。 股市注定是一个1盈2平7亏得地方。

而我,大概率的落到了7亏得那大部分人里。

不想说太多技术的东西。

午盘开盘前,11点多的时候可以跑掉,但是心里总是心存侥幸。 希望下午尾盘能有机会V上去。 股市里最怕的就是这种希望,没有凭借概率说话。

没有概率上的胜率,只能期盼奇迹。 但是,奇迹是小概率事件,期待奇迹的发生,不是一个胜者该做的。

多回顾,多反省,多空仓。 纪律和模式的重要性,会让你能够避免失血过多而在股市存活下来。

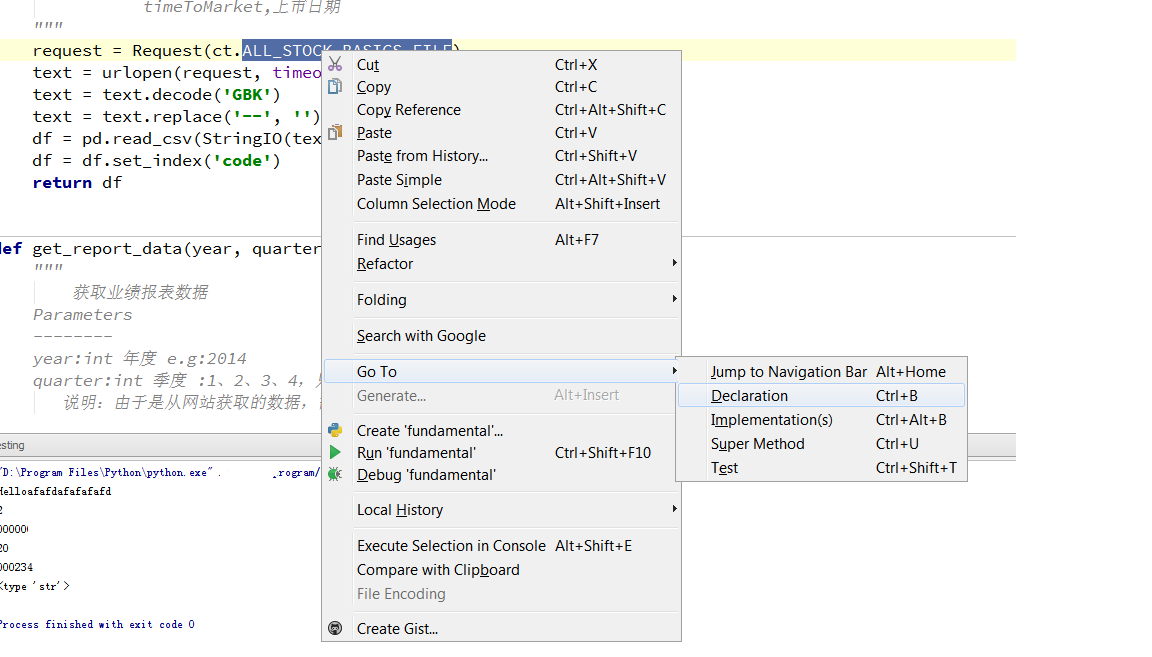

tushare 源码分析 之 fundamental.py

量化交易-Ptrade-QMT • 李魔佛 发表了文章 • 0 个评论 • 14623 次浏览 • 2016-07-22 08:56

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,import tushare as ts

df=ts.get_stock_basics()那么我们来看看get_stock_basics函数的实现。def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}

然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意 df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。 查看全部

下面来具体看看里面的一些具体的函数是怎么实现的。

fundamental.py 这个文件是获取企业的基本面信息的。

比如 在主程序 main中,

import tushare as ts那么我们来看看get_stock_basics函数的实现。

df=ts.get_stock_basics()

def get_stock_basics():

"""

获取沪深上市公司基本情况

Return

--------

DataFrame

code,代码

name,名称

industry,细分行业

area,地区

pe,市盈率

outstanding,流通股本

totals,总股本(万)

totalAssets,总资产(万)

liquidAssets,流动资产

fixedAssets,固定资产

reserved,公积金

reservedPerShare,每股公积金

eps,每股收益

bvps,每股净资

pb,市净率

timeToMarket,上市日期

"""

request = Request(ct.ALL_STOCK_BASICS_FILE)

text = urlopen(request, timeout=10).read()

text = text.decode('GBK')

text = text.replace('--', '')

df = pd.read_csv(StringIO(text), dtype={'code':'object'})

df = df.set_index('code')

return df

上面通过urlib2的Request函数获取url的信息,然后保存为df格式然后返回。

url路径在这个变量里面:

ct.ALL_STOCK_BASICS_FILE

跳转到这个变量

ALL_STOCK_BASICS_FILE = '%s%s/static/all.csv'%(P_TYPE['http'], DOMAINS['oss'])

P_TYPE 和DOMAINS 是字典变量, 在同一个文件内可以找到他们的值:

P_TYPE = {'http': 'http://', 'ftp': 'ftp://'}

DOMAINS = {'sina': 'sina.com.cn', 'sinahq': 'sinajs.cn',

'ifeng': 'ifeng.com', 'sf': 'finance.sina.com.cn',

'vsf': 'vip.stock.finance.sina.com.cn',

'idx': 'www.csindex.com.cn', '163': 'money.163.com',

'em': 'eastmoney.com', 'sseq': 'query.sse.com.cn',

'sse': 'www.sse.com.cn', 'szse': 'www.szse.cn',

'oss': '218.244.146.57', 'idxip':'115.29.204.48',

'shibor': 'www.shibor.org', 'mbox':'www.cbooo.cn'}然后把上面的字典值抽取出来:

那么url就是 http://218.244.146.57/static/all.csv , 你可以试试在浏览器里直接输入。 看到了吗?

可以直接下载一个all.csv格式的文件,打开后可以看到里面很多企业基本面的信息。

获取业绩报表

def get_report_data(year, quarter):

"""

获取业绩报表数据

Parameters

--------

year:int 年度 e.g:2014

quarter:int 季度 :1、2、3、4,只能输入这4个季度

说明:由于是从网站获取的数据,需要一页页抓取,速度取决于您当前网络速度

Return

--------

DataFrame

code,代码

name,名称

eps,每股收益

eps_yoy,每股收益同比(%)

bvps,每股净资产

roe,净资产收益率(%)

epcf,每股现金流量(元)

net_profits,净利润(万元)

profits_yoy,净利润同比(%)

distrib,分配方案

report_date,发布日期

"""

函数主要通过 request = Request(url) 在财经网站获取信息。

request = Request(ct.REPORT_URL%(ct.P_TYPE['http'], ct.DOMAINS['vsf'], ct.PAGES['fd'],year, quarter, pageNo, ct.PAGE_NUM[1]))

text = urlopen(request, timeout=10).read()

Request里面的参数是一个可变量,通过循环的列表来获取所有的公司业绩报表。

通过定位参数里的变量,可以得到随意一个url, 比如 REPORT_URL = '%s%s/q/go.php/vFinanceAnalyze/kind/mainindex/%s?s_i=&s_a=&s_c=&reportdate=%s&quarter=%s&p=%s&num=%s'

那么url =http://vip.stock.finance.sina.com.cn/q/go.php/vFinanceAnalyze/kind/mainindex/index.phtml?s_i=&s_a=&s_c=&reportdate=2014&quarter=1&p=1&num=38

那么直接在浏览器输入看看 是什么数据

看到了2014年第一节度的每个公司的业绩(因为有些是新股,所以2014的数据显示不全)

注意

df=ts.get_report_data(2016,4)

#第四季度就是年报

根据作者的意思,这个参数写4就是年报。 (可以自己根据网址内容去到新浪财经去验证)

新版tushare注册码

https://tushare.pro/register?reg=217168

注册后送积分,只有足够的积分才能够调用一些高权限的接口

待续。

SQL 笔记 (新人会遇到的坑)

Linux • 李魔佛 发表了文章 • 0 个评论 • 2678 次浏览 • 2016-07-18 22:31

这里记录下来,说不定除了能够提醒自己,还能够帮助别人。

1. SQL的表名命名规则跟C,C++的变量命名规则一样,只能包含数字,字母,下划线。 而且不能够以数字开头。

(之前曾经很傻的用日期作为表名,结果一堆报错的。

如果硬要用日期,不妨在前面放一个下划线。

)

查看全部

使用pandas的dataframe数据进行操作的总结

python • 李魔佛 发表了文章 • 0 个评论 • 5683 次浏览 • 2016-07-17 16:47

#使用iloc后,t已经变成了一个子集。 已经不再是一个dataframe数据。 所以你使用 t['high'] 返回的是一个值。此时t已经没有index了,如果这个时候调用 t.index

t=df[:1]

class 'pandas.core.frame.DataFrame'>

#这是返回的是一个DataFrame的一个子集。 此时 你可以继续用dateFrame的一些方法进行操作。

删除dataframe中某一行

df.drop()

df的内容如下:

df.drop(df[df[u'代码']==300141.0].index,inplace=True)

print df

输出如下

记得参数inplace=True, 因为默认的值为inplace=False,意思就是你不添加的话就使用Falase这个值。

这样子原来的df不会被修改, 只是会返回新的修改过的df。 这样的话需要用一个新变量来承接它

new_df=df.drop(df[df[u'代码']==300141.0].index)

判断DataFrame为None

if df is None:

print "None len==0"

return False

查看全部

#使用iloc后,t已经变成了一个子集。 已经不再是一个dataframe数据。 所以你使用 t['high'] 返回的是一个值。此时t已经没有index了,如果这个时候调用 t.index

t=df[:1]

class 'pandas.core.frame.DataFrame'>

#这是返回的是一个DataFrame的一个子集。 此时 你可以继续用dateFrame的一些方法进行操作。

删除dataframe中某一行

df.drop()

df的内容如下:

df.drop(df[df[u'代码']==300141.0].index,inplace=True)

print df

输出如下

记得参数inplace=True, 因为默认的值为inplace=False,意思就是你不添加的话就使用Falase这个值。

这样子原来的df不会被修改, 只是会返回新的修改过的df。 这样的话需要用一个新变量来承接它

new_df=df.drop(df[df[u'代码']==300141.0].index)

判断DataFrame为None

if df is None:

print "None len==0"

return False

安卓系统常用命令 adb shell

Android • 李魔佛 发表了文章 • 0 个评论 • 3816 次浏览 • 2016-07-16 16:44

1. 安卓关机(非重启): adb shell svc power shutdown

2. android开机的时候跳过初始化设置 (setup wizard): adb shell input text 1396611460

3.

1. 安卓关机(非重启): adb shell svc power shutdown

2. android开机的时候跳过初始化设置 (setup wizard): adb shell input text 1396611460

3.

汇金(国家队)最近增持的个股 2016年4月之后

股票 • 李魔佛 发表了文章 • 0 个评论 • 2359 次浏览 • 2016-07-14 22:59

有点意思,个人猜测,有可能是养老金悄悄进入的市场。

保持关注。

雪人股份 继续跟踪 7月12日

股票 • 李魔佛 发表了文章 • 0 个评论 • 2412 次浏览 • 2016-07-12 08:26

所以后期还是可以再介入一波。

雪人股份 后续分析 6月30日 查看全部

所以后期还是可以再介入一波。

雪人股份 后续分析 6月30日

python 爬虫下载的图片打不开?

python • 李魔佛 发表了文章 • 0 个评论 • 6880 次浏览 • 2016-07-09 17:33

代码如下片段

__author__ = 'rocky'

import urllib,urllib2,StringIO,gzip

url="http://image.xitek.com/photo/2 ... ot%3B

filname=url.split("/")[-1]

req=urllib2.Request(url)

resp=urllib2.urlopen(req)

content=resp.read()

#data = StringIO.StringIO(content)

#gzipper = gzip.GzipFile(fileobj=data)

#html = gzipper.read()

f=open(filname,'w')

f.write()

f.close()

运行后生成的文件打开后不显示图片。

后来调试后发现,如果要保存为图片格式, 文件的读写需要用'wb', 也就是上面代码中

f=open(filname,'w') 改一下 改成

f=open(filname,'wb')

就可以了。

查看全部

代码如下片段

__author__ = 'rocky'运行后生成的文件打开后不显示图片。

import urllib,urllib2,StringIO,gzip

url="http://image.xitek.com/photo/2 ... ot%3B

filname=url.split("/")[-1]

req=urllib2.Request(url)

resp=urllib2.urlopen(req)

content=resp.read()

#data = StringIO.StringIO(content)

#gzipper = gzip.GzipFile(fileobj=data)

#html = gzipper.read()

f=open(filname,'w')

f.write()

f.close()

后来调试后发现,如果要保存为图片格式, 文件的读写需要用'wb', 也就是上面代码中

f=open(filname,'w') 改一下 改成

f=open(filname,'wb')

就可以了。

判断网页内容是否经过gzip压缩 python代码

python • 李魔佛 发表了文章 • 0 个评论 • 3791 次浏览 • 2016-07-09 15:10

那么可以在代码中添加一个判断,判断网页内容是否经过gzip压缩,是的话多一个处理就可以了。

深港通标的个股 -- 年内定会开通

股票 • 李魔佛 发表了文章 • 0 个评论 • 2730 次浏览 • 2016-07-07 12:03

linux locate 搜索挂载的分区文件

Linux • 李魔佛 发表了文章 • 0 个评论 • 2742 次浏览 • 2016-07-07 11:17

可以修改updatedb的配置文件来修改sudo gedit /etc/updatedb.conf

把文件中的PRUNEPATHS="/tmp /var/spool /media /home/.ecryptfs"

/media 去掉就可以了。

这个参数是设置忽略哪些查找的路径。

查看全部

一般linux的locate命令会忽略挂载分区的文件,所以即使你挂载分区后使用updatedb也没用。

可以修改updatedb的配置文件来修改

sudo gedit /etc/updatedb.conf

把文件中的

PRUNEPATHS="/tmp /var/spool /media /home/.ecryptfs"

/media 去掉就可以了。

这个参数是设置忽略哪些查找的路径。

股市中的数学 (1)

股票 • 李魔佛 发表了文章 • 0 个评论 • 2838 次浏览 • 2016-07-02 09:54

股价连续n个涨停板后的涨幅是 = (1.1的n次方 -1 )

比如, 新股连续一周涨停板,那么一周的涨幅就是 1.1(**5)-1=61%

1 day's raise is 10.00

2 day's raise is 21.00

3 day's raise is 33.10

4 day's raise is 46.41

5 day's raise is 61.05

查看全部

股价连续n个涨停板后的涨幅是 = (1.1的n次方 -1 )

比如, 新股连续一周涨停板,那么一周的涨幅就是 1.1(**5)-1=61%

1 day's raise is 10.00

2 day's raise is 21.00

3 day's raise is 33.10

4 day's raise is 46.41

5 day's raise is 61.05

定向增发与非公开发行

量化交易 • 李魔佛 发表了文章 • 0 个评论 • 3338 次浏览 • 2016-07-01 23:14

定向增发与非公开发行目前已经是一个概念了。

定向增发是指上市公司向符合条件的少数特定投资者非公开发行股份的行为,规定要求发行对象不得超过10人,发行价不得低于公告前20个交易市价的90%,发行股份12个月内(认购后变成控股股东或拥有实际控制权的36个月内) 不得转让。

2006年证监会推出的《再融资管理办法》中,关于非公开发行,除了规定发行对象不得超过10人,发行价不得低于市价的90%,发行股份12个月内(大股东认购的为36个月)不得转让,以及募资用途需符合国家产业政策、上市公司及其高管不得有违规行为等外,没有其他条件。

感觉不公开的东西才是好东东~

非定向增发的估计都是没人要的。。 查看全部

定向增发与非公开发行目前已经是一个概念了。

定向增发是指上市公司向符合条件的少数特定投资者非公开发行股份的行为,规定要求发行对象不得超过10人,发行价不得低于公告前20个交易市价的90%,发行股份12个月内(认购后变成控股股东或拥有实际控制权的36个月内) 不得转让。

2006年证监会推出的《再融资管理办法》中,关于非公开发行,除了规定发行对象不得超过10人,发行价不得低于市价的90%,发行股份12个月内(大股东认购的为36个月)不得转让,以及募资用途需符合国家产业政策、上市公司及其高管不得有违规行为等外,没有其他条件。

感觉不公开的东西才是好东东~

非定向增发的估计都是没人要的。。

雪人股份 后续分析 6月30日

股票 • 李魔佛 发表了文章 • 0 个评论 • 2590 次浏览 • 2016-06-30 09:05

从27日的龙虎榜信息来看

卖出方并没有出现福州五一路,说明该营业部进行了锁仓。 而从最近2天的调整的套路来看,成交量减少了一半,主力不可能在2天缩量的时候把货出掉,所以判断是锁仓。。 分时上看,一旦股价下跌到最低点(下图中的红圈),就有大单涌进来吸货。 从而并未造成股价大幅下跌。

如果庄家跑路,那么股价就会随自由落体,价格波动幅度会很大。

所有雪人后续还会有一批,建议目前小仓位建仓,等股价拉起来可以继续加仓。

雪人股份 分析贴:

雪人股份 后续分析 6月22日

雪人股份 大宗交易分析 寻找主力痕迹

查看全部

从27日的龙虎榜信息来看

卖出方并没有出现福州五一路,说明该营业部进行了锁仓。 而从最近2天的调整的套路来看,成交量减少了一半,主力不可能在2天缩量的时候把货出掉,所以判断是锁仓。。 分时上看,一旦股价下跌到最低点(下图中的红圈),就有大单涌进来吸货。 从而并未造成股价大幅下跌。

如果庄家跑路,那么股价就会随自由落体,价格波动幅度会很大。

所有雪人后续还会有一批,建议目前小仓位建仓,等股价拉起来可以继续加仓。

雪人股份 分析贴:

雪人股份 后续分析 6月22日

雪人股份 大宗交易分析 寻找主力痕迹

python 下使用beautifulsoup还是lxml ?

python • 李魔佛 发表了文章 • 0 个评论 • 7379 次浏览 • 2016-06-29 18:29

然后看了下beautifulsoup的源码,其实现原理使用的是正则表达式,而lxml使用的节点递归的技术。

Don't use BeautifulSoup, use lxml.soupparser then you're sitting on top of the power of lxml and can use the good bits of BeautifulSoup which is to deal with really broken and crappy HTML.

9down vote

In summary, lxml is positioned as a lightning-fast production-quality html and xml parser that, by the way, also includes a soupparser module to fall back on BeautifulSoup's functionality. BeautifulSoupis a one-person project, designed to save you time to quickly extract data out of poorly-formed html or xml.

lxml documentation says that both parsers have advantages and disadvantages. For this reason, lxml provides a soupparser so you can switch back and forth. Quoting,

[quote]

BeautifulSoup uses a different parsing approach. It is not a real HTML parser but uses regular expressions to dive through tag soup. It is therefore more forgiving in some cases and less good in others. It is not uncommon that lxml/libxml2 parses and fixes broken HTML better, but BeautifulSoup has superiour support for encoding detection. It very much depends on the input which parser works better.

In the end they are saying,

The downside of using this parser is that it is much slower than the HTML parser of lxml. So if performance matters, you might want to consider using soupparser only as a fallback for certain cases.

If I understand them correctly, it means that the soup parser is more robust --- it can deal with a "soup" of malformed tags by using regular expressions --- whereas lxml is more straightforward and just parses things and builds a tree as you would expect. I assume it also applies to BeautifulSoup itself, not just to the soupparser for lxml.

They also show how to benefit from BeautifulSoup's encoding detection, while still parsing quickly with lxml:[code]>>> from BeautifulSoup import UnicodeDammit

>>> def decode_html(html_string):

... converted = UnicodeDammit(html_string, isHTML=True)

... if not converted.unicode:

... raise UnicodeDecodeError(

... "Failed to detect encoding, tried [%s]",

... ', '.join(converted.triedEncodings))

... # print converted.originalEncoding

... return converted.unicode

>>> root = lxml.html.fromstring(decode_html(tag_soup))[/code]

(Same source: http://lxml.de/elementsoup.html).

In words of BeautifulSoup's creator,

That's it! Have fun! I wrote Beautiful Soup to save everybody time. Once you get used to it, you should be able to wrangle data out of poorly-designed websites in just a few minutes. Send me email if you have any comments, run into problems, or want me to know about your project that uses Beautiful Soup.[code] --Leonard[/code]

Quoted from the Beautiful Soup documentation.

I hope this is now clear. The soup is a brilliant one-person project designed to save you time to extract data out of poorly-designed websites. The goal is to save you time right now, to get the job done, not necessarily to save you time in the long term, and definitely not to optimize the performance of your software.

Also, from the lxml website,

lxml has been downloaded from the Python Package Index more than two million times and is also available directly in many package distributions, e.g. for Linux or MacOS-X.

And, from Why lxml?,

The C libraries libxml2 and libxslt have huge benefits:... Standards-compliant... Full-featured... fast. fast! FAST! ... lxml is a new Python binding for libxml2 and libxslt...

[/quote]

意思大概就是 不要用Beautifulsoup,使用lxml, lxml才能让你提要到让你体会到html节点解析的速度之快。

查看全部

然后看了下beautifulsoup的源码,其实现原理使用的是正则表达式,而lxml使用的节点递归的技术。

Don't use BeautifulSoup, use lxml.soupparser then you're sitting on top of the power of lxml and can use the good bits of BeautifulSoup which is to deal with really broken and crappy HTML.

9down vote

In summary,lxmlis positioned as a lightning-fast production-quality html and xml parser that, by the way, also includes asoupparsermodule to fall back on BeautifulSoup's functionality.BeautifulSoupis a one-person project, designed to save you time to quickly extract data out of poorly-formed html or xml.

lxml documentation says that both parsers have advantages and disadvantages. For this reason,lxmlprovides asoupparserso you can switch back and forth. Quoting,

[quote]

BeautifulSoup uses a different parsing approach. It is not a real HTML parser but uses regular expressions to dive through tag soup. It is therefore more forgiving in some cases and less good in others. It is not uncommon that lxml/libxml2 parses and fixes broken HTML better, but BeautifulSoup has superiour support for encoding detection. It very much depends on the input which parser works better.

In the end they are saying,

The downside of using this parser is that it is much slower than the HTML parser of lxml. So if performance matters, you might want to consider using soupparser only as a fallback for certain cases.

If I understand them correctly, it means that the soup parser is more robust --- it can deal with a "soup" of malformed tags by using regular expressions --- whereas

lxmlis more straightforward and just parses things and builds a tree as you would expect. I assume it also applies to

BeautifulSoupitself, not just to the

soupparserfor

lxml.

They also show how to benefit from

BeautifulSoup's encoding detection, while still parsing quickly with

lxml:

[code]>>> from BeautifulSoup import UnicodeDammit[/code]

>>> def decode_html(html_string):

... converted = UnicodeDammit(html_string, isHTML=True)

... if not converted.unicode:

... raise UnicodeDecodeError(

... "Failed to detect encoding, tried [%s]",

... ', '.join(converted.triedEncodings))

... # print converted.originalEncoding

... return converted.unicode

>>> root = lxml.html.fromstring(decode_html(tag_soup))

(Same source: http://lxml.de/elementsoup.html).

In words of

BeautifulSoup's creator,

That's it! Have fun! I wrote Beautiful Soup to save everybody time. Once you get used to it, you should be able to wrangle data out of poorly-designed websites in just a few minutes. Send me email if you have any comments, run into problems, or want me to know about your project that uses Beautiful Soup.[code] --Leonard[/code]

Quoted from the Beautiful Soup documentation.

I hope this is now clear. The soup is a brilliant one-person project designed to save you time to extract data out of poorly-designed websites. The goal is to save you time right now, to get the job done, not necessarily to save you time in the long term, and definitely not to optimize the performance of your software.

Also, from the lxml website,

lxml has been downloaded from the Python Package Index more than two million times and is also available directly in many package distributions, e.g. for Linux or MacOS-X.

And, from Why lxml?,

The C libraries libxml2 and libxslt have huge benefits:... Standards-compliant... Full-featured... fast. fast! FAST! ... lxml is a new Python binding for libxml2 and libxslt...

[/quote]

意思大概就是 不要用Beautifulsoup,使用lxml, lxml才能让你提要到让你体会到html节点解析的速度之快。

python获取列表中的最大值

python • 李魔佛 发表了文章 • 0 个评论 • 4776 次浏览 • 2016-06-29 16:35

list=[1,2,3,5,4,6,434,2323,333,99999]

print "max of list is ",

print max(list)

输出 99999 查看全部

list=[1,2,3,5,4,6,434,2323,333,99999]

print "max of list is ",

print max(list)

输出 99999

换手率 你未必懂的地方

股票 • 李魔佛 发表了文章 • 0 个评论 • 2397 次浏览 • 2016-06-24 18:21

很多人都知道换手率代表一个股票的活跃程度,不过里面还是有一些不为人知的地方。

比如: 近期的新股 中国核建

换手率为0.52%, 看起来很低吧。

可是很多人忽略了一个地方,换手率的公式= 当天成交股票股数/流通股本, 而对于很多新股来说,会有很大部分的禁售股, 中国核建总股本26亿,而流通股才5亿多,超过20亿股本是暂时无法流通的,所以目前在市场上活跃的股本才5亿, 也就是真正的换手率 为 = 当日成交股票股数/流通股本 , 对于中国核建来说,它的实际换手率为 = 2.73万*100/5.25亿 * 100% = 0.52%

而对于新股来说,一般如果换手超过2%,下一天很可能就会开板。对于次新股来说,还可以接到1~2个涨停板左右。

查看全部

很多人都知道换手率代表一个股票的活跃程度,不过里面还是有一些不为人知的地方。

比如: 近期的新股 中国核建

换手率为0.52%, 看起来很低吧。

可是很多人忽略了一个地方,换手率的公式= 当天成交股票股数/流通股本, 而对于很多新股来说,会有很大部分的禁售股, 中国核建总股本26亿,而流通股才5亿多,超过20亿股本是暂时无法流通的,所以目前在市场上活跃的股本才5亿, 也就是真正的换手率 为 = 当日成交股票股数/流通股本 , 对于中国核建来说,它的实际换手率为 = 2.73万*100/5.25亿 * 100% = 0.52%

而对于新股来说,一般如果换手超过2%,下一天很可能就会开板。对于次新股来说,还可以接到1~2个涨停板左右。

同花顺好像很想英国脱欧呀!!!

股票 • 李魔佛 发表了文章 • 0 个评论 • 2830 次浏览 • 2016-06-24 08:34

自己去BBC官网看看? 就拿一个地区数据来说话,要炒股赢钱,千万不能看一个扭曲事实的同花顺。

黄色的remain是留,蓝色的leave是离。

炒股最忌讳的就是用他人的二手过滤过的数据,尤其是用户群巨大的网站社区。 一个有偏颇的数据会引起巨大的涟漪。

查看全部

物联网 标的个股 --延华智能

股票 • 李魔佛 发表了文章 • 0 个评论 • 2862 次浏览 • 2016-06-23 23:33

智慧城市, 建筑节能, 智能医疗,养老概念

今天放量进入龙虎榜单。 涨停原因就是物联网题材的兴起。

先看看延华智能的龙虎榜

买一到买四清一色的机构席位。

而卖出的四个都是游资。

关键还是看看卖出买入占比, 前5买入占了30%,而卖出前5才占17%,差的太多了。

说明买入的是超大单,集中度高; 而卖出的是游资掺杂着很多的散户。而且不少实在涨停板上卖出的,从分价表上可以看出来。

所以上面的4个机构很可能是家机构,明天冲高不能追加。 要看最高后回落情况,如果承接的好,那么说明后面还有肉。 不然冲高就应该减仓。

查看全部